¿Conoces el archivo robots.txt? Los buscadores quieren indexar toda la información posible de los sitios web que visitan. Por ello, cuando llegan a tu página, lo intentan rastrear todo.

Esto puede suponer un problema. Por ejemplo, cuando tu página está en producción y no quieres que aún se muestre en buscadores. Para poder controlar esto tenemos dos opciones:

- Una etiqueta que incluimos en la cabecera del código HTML de nuestra página: la etiqueta META Robots.

- El archivo Robots.txt.

Archivo Robots.txt ¿Qué es?

Es un archivo de texto que se encuentra en la raíz de un dominio y sirve para indicar a los robots de los buscadores qué zonas deseas que puedan rastrear y cuales no.

Al igual que sucede con el archivo sitemap, éste sigue un estándar para que los buscadores puedan interpretar a qué zonas o archivos de la página pueden acceder.

¿Para qué sirve?

Como hemos indicado anteriormente, el archivo Robots.txt se usa para controlar el tráfico de rastreo. Gracias a ello conseguiremos:

- Que los rastreadores de los buscadores no sobrecarguen el servidor de nuestra web.

- Evitar que Google y otros buscadores muestren resultados de tu página que no desees mostrar en las SERP

¿Cómo se crea?

Existe amplia información en Internet sobre este tema. Tienes documentación muy completa en esta página de Google.

Si usas Wordpress, automáticamente al instalarlo te genera el archivo que se ubica en www.tudominio.com/robots.txt

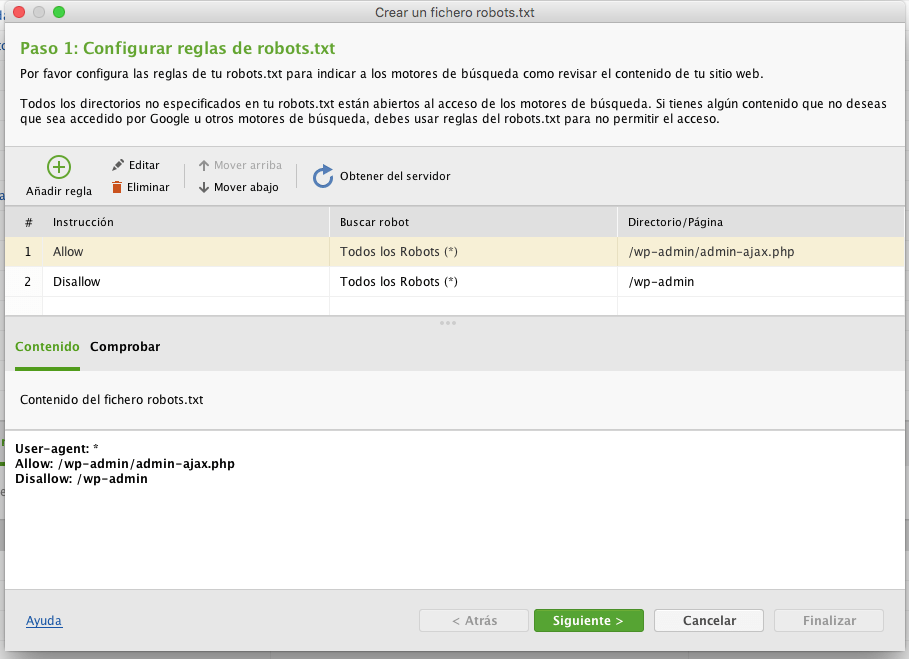

Crea tu archivo Robots.txt con Website Auditor

Con la magnífica herramienta Website Auditor de SEO Power Suite, puedes crear tus archivos Robots.txt sin problema alguno, a través de un asistente en cuestión de segundos.

Más información sobre Robots.txt:

Archivos robots.txt según el CMS

A continuación te facilitamos un archivo robots.txt según el CMS que use tu web, con la configuración óptima que el robots.txt debe tener para impulsar el SEO de tu sitio web. Esto ayudará a que el robot no pierda el tiempo en rastrear página del sitio web que no son relevantes, así conseguiremos optimizar el tiempo que el robot pasa en nuestro sitio, consiguiendo que este se concentre en rastrear un mayor número de veces y más tiempo las páginas importantes de la web.

Robots.txt para Wordpress

Robots.txt para Prestashop

![Curso SEO online – El mejor curso de SEO [2023]](https://cursoseoprofesional.com/wp-content/uploads/2022/01/cropped-cropped-logo-blanco-horizontal_brillo.png)